ceph硬件布置参考

· ☕ 1 分钟 · ✍️ starifly

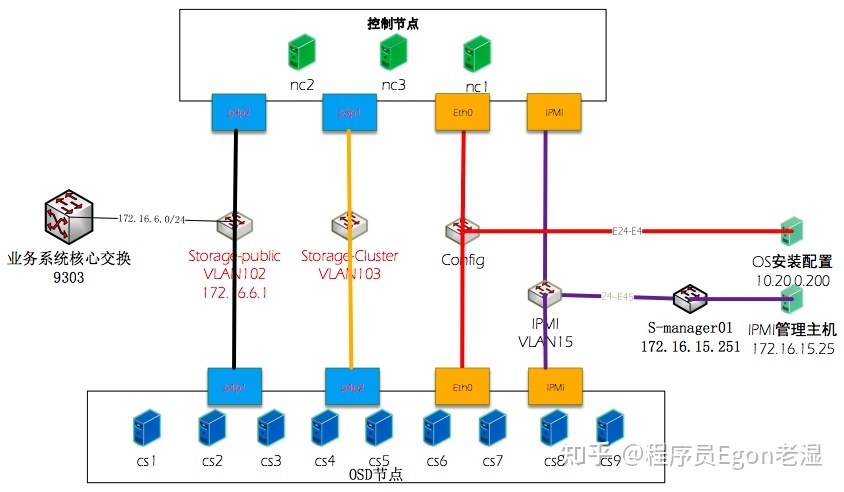

1、网络拓扑参考

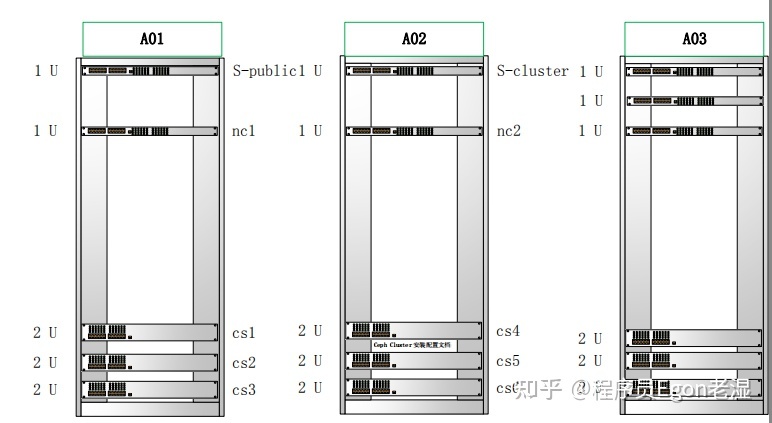

2、设备位置图参考

3、服务器配置信息及运行服务统计

一般来说,内存越多越好。

对于一个中等规模的集群,监视/管理器节点可以使用64GB;对于具有数百个osd的大型集群,128GB是一个合理的目标。

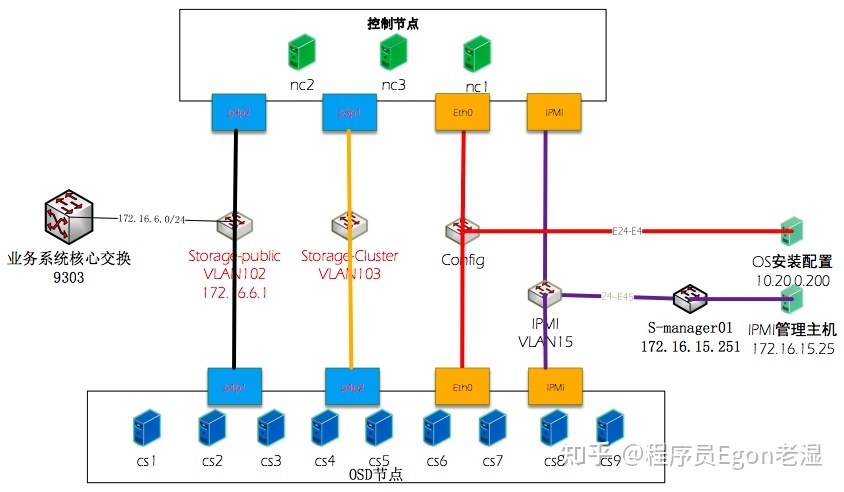

1、网络拓扑参考

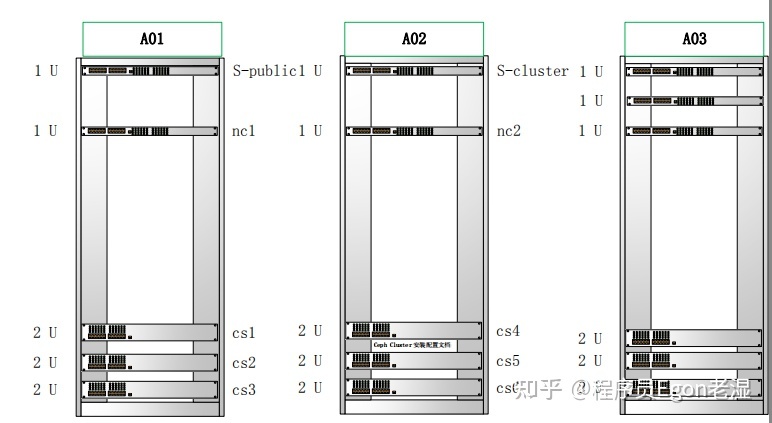

2、设备位置图参考

3、服务器配置信息及运行服务统计

一般来说,内存越多越好。

对于一个中等规模的集群,监视/管理器节点可以使用64GB;对于具有数百个osd的大型集群,128GB是一个合理的目标。

1、执行ceph -s确认存储集群状态,保证为健康状态。

[root@ceph001 ~]# ceph -s

cluster:

id: d00c744a-17f6-4768-95de-1243202557f2

health: HEALTH_OK

services:

mon: 3 daemons, quorum ceph001,ceph002,ceph003 (age 41m)

mgr: ceph001(active, since 43m), standbys: ceph003

mds: cephfs:1 {0=ceoh002=up:active} 2 up:standby

osd: 6 osds: 6 up (since 3m), 6 in (since 3m)

rgw: 3 daemons active (ceph001, ceph002, ceph003)

task status:

data:

pools: 10 pools, 96 pgs

objects: 803 objects, 2.1 GiB

usage: 13 GiB used, 62 GiB / 75 GiB avail

pgs: 96 active+clean

2、执行ceph osd tree ,记录变更前的结构。以及存储池pool及其他信息。

ceph 在同一个集群配置多个zone,但不同 zone 之间的 rgw 不复制,这种情形应该可以适应多租户环境,因为希望每个租户之间的数据是相互独立的,具体配置可以参考 https://access.redhat.com/documentation/en-us/red_hat_ceph_storage/3/html-single/object_gateway_guide_for_red_hat_enterprise_linux/index#configuring-multiple-zones-without-replication-rgw

准备存储池

点击屏幕右上角的 ···

在弹出的窗口中选择 在浏览器中打开